La radio digital ofrece oportunidades para que los radiodifusores compitan por nuevos oyentes en segmentos más definidos y que les repercutan en ingresos; para que la radio pública a su vez tenga la oportunidad acceder a un “canal” de radio bajo la modalidad de la multiplexación sin tener que invertir forzosamente en infraestructura o espectro, y para que los usuarios a través de esta radio reciban más beneficios específicos, como alertas de tránsito, de clima o de emergencias, por ejemplo.

La radio digital tiene un símil en la televisión digital. Con esta tecnología, un ancho de banda por el que transmita una estación de FM puede aprovecharse con la “división” del espectro en más canales, hasta en 4 de ellos y el primero de esos cuatro se destina a la transmisión en digital de la señal análoga original, explicó HD Radio, filial del grupo iBiquity Digital Corp que desarrolló la tecnología para este tipo de transmisiones y que ya es utilizada en algunas emisoras de México y en todo Estados Unidos, donde esta tecnología logra una penetración del 90 %.

La radio digital utiliza hasta ocho veces menos energía en enviar las señales a los receptores, lo que significa la optimización de recursos.

Los esfuerzos para crear un sistema de radiodifusión digital comenzaron durante la década de los 1980s. En Europa los estudios se canalizaron a través del proyecto Eureka 147 y el fin principal era la ganancia en calidad, dando lugar a DAB.

En Estados Unidos, Ibiquity lideró el diseño del nuevo sistema, teniendo como principal objetivo un sistema muy adaptativo que permitiera un cambio gradual de los receptores, dando lugar a IBOC.

Actualmente, existen tres sistemas de radiodifusión digital: IBOC (In-band On-channel), DAB (Digital Audio Broadcasting) y DRM (Digital Radio Mondiale). IBOC se ha implantado con relativa facilidad en los países que adoptaron este sistema.

Los esfuerzos para crear un sistema de radiodifusión digital comenzaron durante la década de los 1980s. En Europa los estudios se canalizaron a través del proyecto Eureka 147 y el fin principal era la ganancia en calidad, dando lugar a DAB.

En Estados Unidos, Ibiquity lideró el diseño del nuevo sistema, teniendo como principal objetivo un sistema muy adaptativo que permitiera un cambio gradual de los receptores, dando lugar a IBOC.

Actualmente, existen tres sistemas de radiodifusión digital: IBOC (In-band On-channel), DAB (Digital Audio Broadcasting) y DRM (Digital Radio Mondiale). IBOC se ha implantado con relativa facilidad en los países que adoptaron este sistema.

Noruega finalizará la radio en Frecuencia Modulada (FM) en el 2017 para pasar al sistema de emisiones digitales, lo cual lo convierte en el primer país del mundo en realizar esta acción.

La FM será reemplazada por el estándar DAB (Digital Audio Broadcasting), con la cual ya operan 22 emisoras en Noruega donde 55 % de los hogares posee un aparato adaptado para DAB.

DAB está disponible en Noruega desde 1995, y tuvo una actualización a DAB+ en 2007, una versión evolucionada que ofrece una mejor calidad de audio, nuevas funcionalidades (como un sistema de emergencia), además de brindar mayor capacidad para emisoras con cobertura nacional.

Pese a que DAB ya se encuentra en una considerable cantidad de hogares, aún existen 7.9 millones de radios FM, además de los transistores presentes en 80% del parque automovilístico del país, que no podrán adoptar el nuevo sistema.

DAB ha sido adoptado como sistema de transmisión de radio en partes de Europa y Asia.

NORMAS TECNICAS DE RDT

La Radio Digital Terrestre ( RDT) es un sistema de radiodifusión publico de audio, con emisión de señal digital. Actualmente existen tres sistemas de radiodifusión digital a nivel mundial: DAB (Digital Audio Broadcasting), IBOC (In-band On-channel) y DRM (Digital RadioMondiale)

DAB (Digital Audio Broadcasting). En 1995, fue aprobado como el estándar para Europa (ETSI

300 401). El WorldDMB Forum es el organismo encargado de la definición de los estándares de la familia Eureka 147, que incluye DAB y DAB+ para radio digital y DMB para radio multimedia y televisión móvil.

Hoy en más de 30 países se ofrecen regularmente servicios basados en DAB, sumando más de 1.300 servicios multimedia distintos. Existen más de 500 millones de oyentes potenciales alrededor del mundo y se han vendido más de 12 millones de receptores DAB.

DAB utiliza una técnica de codificación y compresión de audio muy eficiente, denominada MPEG Audio

Layer II (MP2) o Musicam. Así, mientras una señal digital estéreo como la del CD necesita una capacidad de 1,4 Mbps, con MP2 se necesitan sólo 192 kbit/s sin afectar prácticamente a la calidad,

Junto con el transporte de la señal de audio, DAB permite el envío de texto ofreciendo más detalles

que el sistema RDS (Radio Data System) de FM, de manera que se puede mostrar en los receptores digitales numerosa información complementaria a la emisión, como la emisora, el título de la canción, noticias sobre el tráfico o el clima, publicidad, etc.

DAB emplea modulación OFDM (Orthogonal Frequency Division Multiplex), que permite el establecimiento de redes de frecuencia única o SFN. Con OFDM se emplean técnicas de corrección de errores FEC (Forward Error Correction). OFDM reduce así las interferencias entre emisoras y las que sufren las transmisiones convencionales debidas a la propagación multi-trayecto (vehículos en movimiento).

En 2007 se estandarizó DAB+ (ETSI TS 102 563), ofreciendo compatibilidad hacia atrás con DAB y más cobertura, mayor eficiencia espectral, costes de transmisión más bajos, posibilidad de sonido envolvente, mayor robustez, bajo retardo en el “zapping” entre emisoras, etc. DAB+ es más del doble de eficiente que DAB, al usar el códec de compresión de audio más eficiente: HE-AAC v2 (MPEG-4 High Efficiency AAC v2 profile). DAB soporta entre 8 y 10 servicios en un multiplex de 1 MHz, mientras que DAB+ puede acomodar de 20 y 30 servicios de radio en el mismo espectro. Además la calidad de la recepción es más robusta en DAB+ que en DAB, ya que incluye la codificación de corrección de error Reed-Solomon.

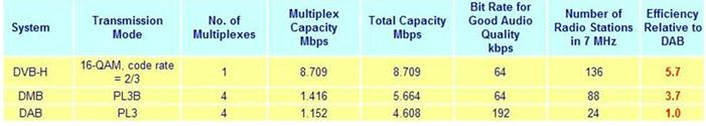

DAB+ introduce capacidades adicionales de vídeo y multimedia con DMB (Digital Multimedia Broadcasting), lo cual lo han convertido en una plataforma de radio digital multimedia e incluso de televisión móvil digital. DMB (ETSI TS 102 428) permite la difusión de un amplio rango de servicios de televisión interactivos simultáneamente en el mismo multiplex (servicios de vídeo, servicios de radio DAB y DAB+, descarga de ficheros o podcasting, guía electrónica de programación o EPG, etc.). En el espectro de un multiplex de 1,5 MHz se pueden ofrecer alrededor de 7 servicios DMB. Hoy DMB es el estándar de TV móvil más exitoso del mundo, con servicios comerciales en algunos países de Europa y Asia y más de 8 millones de dispositivos vendidos.

DRM (Digital Radio Mondiale)

El DRM es un sistema digital para las bandas de radiodifusión con modulación de amplitud, Onda Larga (ondas kilométricas), Onda Media (ondas hectométricas) y Onda Corta (ondas decamétricas), por debajo de 30 MHz. fue aprobado en el año 2003 por la UIT (recomendación ITU-R BS 1514) y recomendado en las bandas entre 3 y 30 MHz (Onda Corta).bn También ha sido estandarizado por la norma IEC-62272-1 y por la ETSI ES-201980.

DRM cubre bandas de radiodifusión: en Amplitud Modulada (onda larga, onda media y onda corta) y en Frecuencia Modulada también conocido como DRM+.

HD Radio

HD Radio ha sido desarrollado por Ubiquity.

PERU: MTC COMBATE PIRATERIA DE RADIO Y TV

Mientras otros países sigen promoviendo la radio digital, en el Perú se sigue insisitiendo con la radio analógica.

El Ministerio de Transportes y Comunicaciones (MTC) anunció la instalación de equipos automatizados en 15 ciudades del Perú para combatir la piratería de señales de radio y televisión.

Se trata de torres metálicas de 30 metros de altura, que contarán con equipos y aparatos de fabricación alemana para detectar a las estaciones transmisoras de los servicios de telecomunicaciones que no cuenten con la correspondiente autorización, y que interfieran y distorsionen las señales radioeléctricas de las empresas autorizadas y de radionavegación aérea.

La instalación de los primeros equipos automatizados en las Estaciones de Control del Espectro Radioeléctrico (Estación CER) del MTC comenzará en los próximos días en Chimbote, Huaraz, Huánuco, Cajamarca y Juliaca. Luego se irán expandiendo por Ica, Pisco, Ayacucho, Tacna, Pucallpa, Tarapoto, Andahuaylas, Chiclayo, Puerto Maldonado y Tumbes.

La instalación se llevará a cabo con el apoyo de personal de un consorcio alemán-colombiano. Según adelantó el MTC, los equipos y antenas no se ubicarán en zonas urbanas ni generarán efectos negativos al ambiente. Tampoco se ubicarán cerca de antenas de radio y televisión, explicó Lorenzo Orrego, Director General de Control y Supervisión de Comunicaciones del MTC.