Una alternativa para conectividad en zonas rurales se ha empezado a ofrecer en Perú, se trata de la marca India, Omoco, que brinda productos diseñados especialmente para esos segmentos a los que no llegan los operadores tradicionales por un tema de costos e inaccesibilidad geográfica.

Ofrece un equipo que permita crear una red de Internet y telefonía móvil para 500 usuarios que entra en una mochila y pesa 5 kilos.

Sandeep Kohli, director de desarrollo de negocios para América Latina de Omoco powered by VNL, informó que su oferta llegará para empezar a utilizarse pronto en por lo menos 13 regiones (Cusco, Cajamarca, Ucayali, Ancash, Apurímac, Huánuco, Provincias de Lima, San Martín, Amazonas, Ayacucho, Puno, Piura y Loreto). Dicha labor la harán en conjunto con

Mayu Telecomunicaciones.

El equipo está diseñado para integradores que deseen ofrecer el servicio de telefonía 2G y mensajería en un radio de 5 km sin necesidad de que haya llegado la red de fibra o señal satelital al pueblo en el que se instalará. Ya ha sido desplegado en zonas rurales de México, Colombia, algunas partes de Asia y la India.

Kohli asegura que las ventajas que ofrece es que son fáciles de instalar y manipular, tienen un bajo costo (menos de US$10 mil por equipo) que la convierte en rentable para pequeños empresarios de las comunidades y logra un impacto positivo en el nivel de vida de las personas que habitan en zonas alejadas de las ciudades.

Esta oferta entraría como una alternativa más para reducir la brecha digital en el país. Será una opción frente a las otras formas que existen para conexión en zonas de difícil acceso geográfico para las redes de fibra, tales como las que ofrecen los grandes fabricantes Google (globos) o Facebook (drones).

OMOCO en MEXICO

Omoco llegó a México en el 2016 con la intención de desplegar 1000 nuevos sitios de cobertura móvil de la mano de socios mexicanos.

Omoco es una compañía india fabricante de small-cells, enfocadas en la reducción de costos operativos (Opex) y de capital (Capex) en el despliegue de nuevas redes móviles. Sus cajas permiten conectividad 2G, LTE, y WiFi, van desde 6,000 hasta los 9,000 dólares. Por ello, su objetivo es proveer de conectividad áreas incomunicadas que van desde zonas rurales sin ningún tipo cobertura, hasta edificios como hoteles, centros comerciales, hospitales y escuelas en zonas urbanas que requieren mejorar la señal celular existente.

Omoco ya trabaja con tres socios en México que esperan desplegar 5 redes en zonas cercanas a la ciudad. México tiene la penetración móvil más baja de América Latina con 85 % de la población. Asimismo, cifras de INEGI estiman que 6 % de la población se encuentra fuera de las zonas de cobertura móvil. El uso de Internet también se mantiene rezagado entre las familias. Según cifras del programa México Conectado, en promedio 29 % de los hogares en localidades urbanas tienen acceso a Internet, porcentaje que se reduce a sólo 6 % en localidades rurales.

Además de permitir el incremento en la cobertura móvil, Omoco busca también ofrecer una oportunidad de negocio para cualquier persona que desee instalar una nueva red móvil en su propia comunidad, con lo que se podrían convertir en operadores móviles locales, establecer tarifas y vender equipos celulares.

Omoco señala que tiene presencia en

17 países con 3,000 redes desplegadas. Omoco indicó “creamos un transmisor de señal celular que cabe en una mochila y consume tan poca energía que puede ser alimentada con una celda solar”. La solución de Omoco para pequeñas comunidades pesa unos 5 kilogramos y puede servir hasta a 300 suscriptores.

Omoco se concentró en hacer que la solución sea lo más sencilla de instalar, "acompañamos nuestro equipo con un instructivo que permite que una persona sin conocimientos de ingeniería pueda hacer uso de nuestra solución”. En el mundo hemos vendido nuestra solución no sólo a empresas: líderes comunitarios, grupos de vecinos; organizaciones no gubernamentales y muchos otros han adquirido nuestras soluciones para comunicar a sus comunidades señaló Omoco.

Pero las comunicaciones comunitarias no son el único mercado al que apuntan sus soluciones; también pueden desplegarse en industrias como plataformas petroleras, minas e instalaciones ubicadas en zonas alejadas de las zonas de cobertura celular. “El problema con las redes celulares tradicionales es que es muy difícil moverlas en caso del cierre de una mina o el movimiento de una instalación de extracción petrolera”, por lo que desean aprovechar la flexibilidad de sus soluciones, que pueden ser instaladas y desplegadas a petición del usuario con posibilidad de proporcionar sistemas de comunicación por datos y control de sistemas SCADA (Supervisory Control and Data Acquisition) para aplicaciones industriales.

Aunque otros fabricantes como Ericsson y Huawei han impulsado la oferta de small-cells para cobertura exterior e internet, Omoco indica que su producto está diseñado y probado para mejorar la cobertura en zonas de difícil acceso. “Los grandes proveedores no se acercarán a las poblaciones pequeñas, porque lo habrían hecho ya. Básicamente no tenemos competidores”.

Entre otros beneficios de las small-cells se encuentra que puede crear redes locales en oficinas, por ejemplo, para permitir llamadas gratis entre los usuarios conectados. Además, en caso de emergencia o desastre natural, se pueden montar un par de cajas en un helicóptero para monitorear una zona, obtener los números celulares, y ofrecer un aproximado de la gente que haya sido afectada o esté desaparecida en esa zona en particular.

ANTECEDENTES

Uno de los principales retos en latinoamerica es incrementar la cobertura de redes móviles para permitir, principalmente a la población rural y de escasos recursos, el acceso a nuevos servicios de comunicación.

El servicio móvil es zonas rurales es básicamente 3G

El cual se complementa con servicios Satelitales básicamente para TV de paga

PERU - TELEFONICA EN BANDA Ka

La Banda Ka, se expandirá de 5 regiones del norte del Perú a 14 regiones en el 2017, informó Oswaldo Pelaes León, gerente de Planificación de Acceso de Telefónica del Perú.

La banda Ka comprende entre los

26,5 GHz y 40 GHz. Cuando se implemente a nivel nacional. permitirá brindar internet de alta velocidad, redes privadas virtuales o como red de transporte, con velocidades de “18 Mbps de bajada hasta 3 Mbps de subida”, afirmó Pelaes.

A la fecha, la Banda Ka se ha implementado en localidades rurales de las regiones

Piura, Lambayeque, Amazonas, Cajamarca y Tumbes; y en el 2017 se tiene proyectado implementarla en 14 regiones adicionales.

En el orden de costos, es mayor el gasto por tender las redes de la

fibra óptica, seguido por las

microondas y la banda

satelital. Esta última reduce en un tercio el costo de la primera.

La diferencia entre la fibra óptica y la banda satelital es que la segunda tiene retrasos de alrededor de 250 milisegundos, mientras la transferencia de la primera es inmediata.

La

Banda C (para la señal de televisión con antenas). Esta necesitaba antenas de 2.4 a 5 metros de diámetro. La evolución es la

banda KU, con un menor diámetro de 1.2 a 1.8 metros.

SKYNET EN COLOMBIA Y PERU

Skynet, subsidiaria de la Empresa de Telecomunicaciones de Bogotá (ETB), prepara su ingreso a Perú, donde brindará conectividad satelital de alta velocidad, además de otros servicios TICs.

“SkyNet se ha posicionado como el primer operador de Internet satelital de la amazonía, ofreciendo banda ancha en la frontera de Colombia, Perú y Brasil”, dijo el gerente de operaciones René Otero.

ETB adquirió el 75 % del operador en 2014 por 10 millones de dólares. En su Colombia natal, Skynet brinda conectividad satelital en la región amazónica y ganó una licitación para implementar 640

kioscos Vive Digital.

3G EN AMAZONIA PERUANA

El uso de tecnologías clásicas, macroceldas y backhaul satelital no asegura el retorno de inversión en poblaciones por debajo de 1.000 habitantes con dispersión de la población, dificultades de acceso y falta de suministro eléctrico, por ello desincentiva a los operadores de telefonía celular a servir a zonas aisladas de la selva.

El proyecto europeo

TUCAN3G, en el que participan centros de investigación, operadoras y fabricantes de equipos, dirigidos técnicamente por la Universidad Rey Juan Carlos (URJC), busca acercar la tecnología 3G a lugares remotos de países en desarrollo.

Para proporcionar un modelo de negocio sostenible, plantea el uso de antenas

femtoceldas y unbackhaul (la red que conecta a los usuarios con la central del operador) alternativo basado en tecnología

WiLD (WiFi modificada para larga distancia).

El proyecto ha logrado la integración y optimización de ambas tecnologías con un bajo coste de despliegue y un bajo consumo eléctrico alimentados con

energía solar. La instalación piloto en la selva peruana ha permitido verificar esta solución técnica y a la vez económicamente sostenible para la introducción progresiva de los servicios de voz y datos de banda ancha en estas comunidades aisladas de menos de 250 habitantes.

El consorcio TUCAN3G ha tenido que solucionar problemas regulatorios, técnicos (control de interferencias, reducción de consumo, optimización de enlaces WiFi de decenas de kilómetros, control de la calidad de servicio) y de homologación de equipos para finalmente poder instalar la tecnología en 6 pueblos en las orillas de los ríos Napo y Paranapura, en Loreto, Perú.

Al cierre del proyecto los investigadores estarán verificando las hipótesis económicas de partida, para comparar ingresos y gastos reales, y así plantear el escalado de la iniciativa.

Los resultados que se están obteniendo se recogen en un artículo que el consorcio ha publicado en la revista científica IEEE Communications Magazine, .

El sistema está funcionando desde febrero de 2016 y ha alcanzado ya un promedio de 120 llamadas diarias por ubicación. Se espera que se alcancen pronto las 200 llamadas diarias, que harán que el servicio sea sostenible. El sistema ha servido ya para coordinar traslados urgentes de pacientes, para hacer que abuelos de la etnia chayahuita conozcan a sus nietos migrantes usando videoconferencia y para que productores de plátano negocien antes de viajar por el río el precio de su producto.

Este trabajo ha sido financiado por el VII Programa Marco de la Comisión Europea (TUCAN-3G / IST-601102 STP) y por el Fondo de Inversión de Telecomunicaciones de Perú (FITEL).

ESTUDIO de PwC

El informe "Conectando al mundo: diez mecanismos de inclusión global" realizado por PwC para Facebook destaca el actual panorama de conectividad a Internet en el mundo, donde el crecimiento en conectividad se ha desacelerado pese a existir todavía 56% de la población sin Internet.

El informe señala que la asequibilidad es una de las principales barreras para incrementar la conectividad. Se requieren medidas en los 3 mercados que componen Internet: proveer de mejor conectividad, contenido relevante y mejores propuestas de valor.

Sobre la base de un análisis econométrico de 120 países, el estudio afirma que lograr la penetración universal a Internet podría ampliar la producción mundial en

6.7 billones de dólares.

Para la medición de asequibilidad, el estudio considera un monto de consumo de

500 MB por persona, Sobre esta base, estima que pese a que 96 % de la población global vive bajo la cobertura de las redes de telecomunicaciones, 67 % de la población no puede acceder a Internet a causa de que un plan de 500 MB cuesta más de 5 % de su ingreso disponible mensual.

Para

América Latina, existe disponibilidad de red para 98% de la población, así como contenido relevante para 92 %, pero que Internet es asequible sólo para 36 %.

Para alcanzar una mayor asequibilidad debe reducirse los precios en aquéllos países con baja conectividad y altos niveles de pobreza. Para obtener 80 % de su población en línea, por ejemplo, Etiopía, Nigeria y Filipinas deberían provocar un recorte en el precio del acceso a Internet por más de 90 %. Los precios en México deberían reducirse 60 % y en Brasil 68 %.

La instalación o mejora de la tecnología en las naciones en desarrollo, será suficiente para llevar a cabo gran parte de esta reducción de costes. Por ejemplo, la gran mayoría de telefonía móvil es utilizado para Internet

2G, si se actualizara a 3G o 4G, el costo de los datos móviles se desplomaría. Sin embargo, requiere inversión por adelantado, no sólo por los operadores, sino también por los usuarios, quienes deben comprar dispositivos móviles relativamente más caros.

Hay tensión entre la necesidad de invertir en activos de red y la necesidad de reducir los precios. El reto de equilibrar la inversión contra la rentabilidad es particularmente grave en los países en desarrollo. Los operadores en la mayoría de estos mercados ya cobran precios muy bajos y tienen un margen negativo en los datos, lo que hace que sea difícil para ellos cortar aún más los precios.

El objetivo de

Internet.org, proyecto fundado y financiado por Facebook, es buscar alianzas con los operadores de telecomunicaciones para ofrecer acceso asequible, pero restringido al acceso de algunas páginas parte del programa como el propio Facebook o Wikipedia. El programa ha sido criticado por ser contrario a las reglas de la “neutralidad de la red”.

Mientras que la “tasa cero” proporciona acceso a una versión más reducida de Internet que la web completa, se considera como una oportunidad para exponer la oferta de valor de Internet a personas que no lo conocen o que es su primer experiencia.

Contenidos: el reporte de PwC indica que en países en desarrollo existe una enorme brecha de acceso a contenido relevante o atractivo para los usuarios. el mercado para el contenido es complejo y fragmentado. Se compone de numerosos submercados, incluidos entretenimiento, información, servicios públicos, servicios empresariales, plataformas de intercambio y comunicación.

Mientras los usuarios en países desarrollados observan 267 videos per cápita, se reduce a 33 en países en desarrollo. En el segmento de información, en países desarrollados existen 12 periódicos por cada millón de habitantes, se reduce a 1.9 en países en desarrollo.

Los creadores de contenido tendrán que dar a los potenciales usuarios razones para pagar por el contenido. Estas necesidades son en su mayoría sobre educación, servicios públicos y aumento de los ingresos. Es necesario que los operadores y vendedores de servicios en Internet cambien su enfoque de ventas de estar centrado en el producto por sí mismo, a un enfoque centrado en el usuario, a través del cual éste último aprenda los beneficios de estar en línea.

“Las investigaciones muestran que estos consumidores más pobres no adoptan fácilmente nuevos productos. Por el contrario, buscan la ayuda de una fuente de confianza antes de que intenten nuevos bienes o servicios”, indica el estudio.

Los diez mecanismos propuestos para incrementar la conectividad en el mundo son:

1. Redistribuir el espectro fuera de 2G: el Internet se vuelve más asequible.

2. Mejorar la distribución de contenidos sin conexión: descargar contenido en la caché local.

3. Más infraestructura Nac.e Intert. de Internet: los precios de acceso a Internet son más baratos.

4. Contenidos educativos relevantes: proporciona una razón de peso para conectarse.

5. Servicios sociales en línea: participar con su gobierno y ser menos vulnerables a la corrupción.

6. Contenido de oportunidades económicas: la gente se conecta porque pueden ganar más

7. Modelos de venta: educación a consumidores antes de adquirir bienes o servicios nuevos.

8. Acceso subvencionado por marcas o suscripciones: da a los más pobres el acceso barato.

9. Propuestas más simples de valor: reduce el riesgo financiero para los nuevos usuarios.

10. Tecnologías disruptivas: las innovaciones tecnológicas a las zonas más pobres y remotas.

WATLY

Watly es un proyecto nacido en Barcelona, el empresario italiano Marco Attisani junto con personas de diversas partes del mundo, han trabajado desde 2013 en lo que ellos llaman "el primer ordenador termodinámico que funciona con energía solar en el mundo", que sería capaz de proporcionar

agua potable, electricidad e internet.

Watly ha logrado reunir más de 22 millones de dólares en inversión desde 2013, se han hecho acreedores a diversos premios de donde se destaca Horizon 2020 patrocinado por la Comisión Europea,

La versión 2.0 ha estado operando desde 2015 en la pequeña villa de Abenta, en Ghana, donde proporciona agua potable, electricidad y conexión 3G a cerca de 750 personas. Ya está en etapa de planificación la versión 3.0 de Watly, que aumentaría su tamaño y capacidades, con el objetivo de llegar a comunidades que superen los 3000 habitantes.

La

versión 3.0 (40m de largo, 15m de ancho y peso 15 toneladas) Utilizaría 40 paneles fotovoltaicos en la parte superior de la estructura capaces de generar hasta 70 kWh por día, la cual estaría disponible por medio de enchufes y cargadores de baterías portátiles.

Esta energía también serviría para purificar aguas residuales o agua de mar por medio de un proceso de destilación por compresión de vapor, proceso que elimina patógenos, residuos de sal, metales pesados y compuestos inorgánicos. Este sistema sería capaz de purificar hasta 5.000 litros de agua por día y su vida útil se estima será de 15 años, además de que su mantenimiento sería mínimo.

Además contaría con un sistema para conectarse vía satelital o a través de antenas 3G o 4G, esto para proporcionar una conexión a internet con un radio de 500 metros, la cual serviría tanto para saber el estatus del dispositivo de forma remota, así como para mantener informada y conectada a la comunidad.

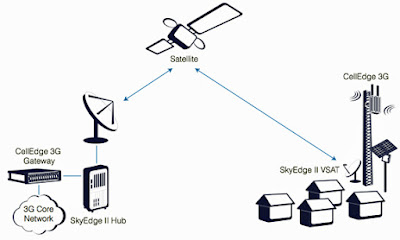

Gilat e Intelsat se unen para mayor cobertura

Aunque en las grandes ciudades tenemos cada vez más y mejor cobertura, en las zonas rurales, en las regiones parcialmente despobladas o en las aisladas geográficamente, las redes móviles tienen poca cobertura o son de muy baja calidad. Sin embargo, hay nuevas soluciones tecnológicas para atender a un gran número de usuarios potenciales.

Gilat Satellite Networks, formó una alianza con

Intelsat para llevar las redes móviles 2G y 3G por

satélite a las zonas más lejanas del Planeta utilizando una serie de estaciones base a modo de

small cells que son las encargadas de conectarse con la red de satélites de Intelsat en órbita y de crear la red móvil en tierra para dar cobertura a áreas extensas.

La primera implementación de su sistema la están llevando a cabo para la operadora

RuralCom en Vancouver, dando cobertura a más de 1.000 millas en la zona de la Columbia Británica y la autopista de Alaska.

Virgin y Qualcomm tamnién formaron una alianza enfocada a dar servicios de voz y datos desde su red de satélites, la cobertura de la Banda Ancha móvil está llamada a llegar hasta los rincones más perdidos de la Tierra.

Google, con sus diversos proyectos como

Loon y la reciente inversión en

SpaceX, también auestan por la combinación de satelite con redes móviles

Cotización en Nasdaq

Cotización en Tel-Aviv Stock Exchange ( TASE)

GRUPO MER

Fundado en 1948 (Israel), el MER Group mantiene un portafolio diversificado con más de 12 subsidiarias enfocadas en tres sectores principales – telecomunicaciones, seguridad y CleanTech – a la vez que invierte en otras áreas incluyendo comunicaciones por satélite, biotecnología y ciencias de materiales. Con cotización pública ( Tel-Aviv Stock Exchange TASE: CMER) desde 1992, el MER Group tiene 40 oficinas en todo el mundo que dan empleo a más de 1.200 personas. www.mer-group.com