LA TASA GOOGLE o CANON AESE

En 2014 España decidió aprobar la Ley de Propiedad Intelectual, que incluía el Canon AEDE, más conocido como Tasa Google. La idea era obligar a Google a pagar por indexar a medios de comunicación españoles, objetivo perseguido por los editores españoles. Ahora es la Unión Europea , a través de la Comisión Europea, quien valora implantar la Tasa Google en todo el continente.

La Comisión Europea realizó una consulta pública al respecto a lo llamado

derechos conexos, que es el concepto utilizado en el mundo anglosajón para referirse a la

propiedad intelectual, en el sector editorial. Es el argumento de los propietarios del contenido para querer cobrar por la difusión del mismo en webs registradas dentro de la Unión Europea.

Actualmente el consenso es cada vez más claro en torno al Canon AEDE: ha resultado ser un fracaso. Google News cerró su servicio en España tras la aprobación de la Tasa Google y los medios de comunicación adscritos no han visto un euro, pero sí han perdido algo por el camino: tráfico web. Pese a ello, no se rinden y ahora quieren dar el salto a la Unión Europea.

La consulta ya se ha cerrado, y de momento no hay datos sobre su resultado. Esta iniciativa por parte de la Comisión Europea tiene lugar en medio de la tormenta que se produce actualmente en torno a empresas como Google, señaladas por utilizar todos los métodos existente de ingeniería fiscal para pagar menos impuestos.

MERCADO UNICO DIGITAL (DSM - Digital Single Market)

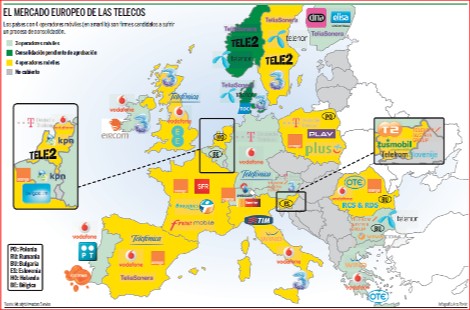

El estandar GSM, que resolvía por la vía tecnológica y del consenso el uso del móvil en toda Europa, hizo innecesaria la drástica medicina corporativa que se impuso en EEUU para garantizar una cobertura "sin costuras". Además, Bruselas y los estados miembros, obsesionados con

bajar los precios, impusieron un tercer, un cuarto y hasta un quinto operador por país y la entrada de los llamados OMV (Operadores Móviles Virtuales), lo que multiplicó el número de competidores y llevó la competencia por precios a cotas nunca vistas.

El

nacionalismo económico ha sido el primer factor disuasorio a las fusiones de telecos en Europa., ya que muchos Estados aún consideran a "su telefónica" una compañía de bandera. Veinte años después de la liberalización del sector, Alemania, Francia, Holanda o Suecia, por citar sólo los casos más notorios, mantienen aún paquetes de control sobre sus antiguos monopolios telefónicos. Y aún son muy pocas las operadoras estatales que hayan sido vendidas a un operador extranjero

Otro factor fundamental para la no consolidación europea es la falta de un mercado financiero y bursátil unificado, que eleva el miedo de los Gobiernos a perder un peso pesado de su bolsa -

Telefónica en España,

Deutsche Telekom en Alemania u

Orange en Francia están entre las empresas con mayor capitalización de cada mercado nacional- si cae en manos extranjeras.

La consolidación ha empezado a acelerarse en Europa debido a la fuerte crisis y la competencia de los negocios de Internet que ha castigado los márgenes de todos los operadores móviles. Pero

las fusiones han sido hasta ahora básicamente nacionales, para reducir el número de actores en cada país y mejorar la rentabilidad de los supervivientes como está sucediendo en España. Un proceso de concentración a gran escala en el que los grandes grupos nacionales caigan en manos foráneas parece todavía lejano.

Europa ha planteado el

Mercado Único Digital como remedio a la debilidad y el retraso, pero sus planteamientos son poco ambiciosos. Para empezar, si el Mercado Único tuviera éxito de verdad -un verdadero mercado único de productos, servicios y contenido digitales de todo tipo, con una regulación homogénea en todos los ámbitos- y fuera más allá del tipico brindis al sol comunitario, lo que está claro es que los

principales beneficiarios de un mercado unificado desde Cornualles a los Urales serían, precisamente, los

gigantes estadounidenses de Internet, que son los que tienen tamaño y escala para operar directamente en toda Europa.

El Mercado Único, lo "único" que haría seria facilitarles las cosas al poder centralizar sus actividades desde Irlanda -o desde el estado dispuesto a hacer el dumping fiscal más avanzado, como Luxemburgo- ahorrándoles los despliegues que ahora tienen que hacer país por país, para adaptarse a las regulaciones castizas.

Si Bruselas centralizara las

subastas de frecuencias y sólo diera, por ejemplo, 4 licencias para toda Europa en la nueva subasta de frecuencias de

700 MHz -algo imposible porque algunos países como Alemania, ya la han adjudicado-, los operadores estarían obligados, como mínimo, a federarse en grandes coaliciones para optar a esas escasas licencias. Y esas coaliciones acabarían con una integración corporativa en pocos años. Pero para ello, los Estados nacionales deberían ceder sus competencias sobre las frecuencias -lo que significa también ceder su control sobre las televisiones, siempre un arma electoral de grueso calibre- algo a lo que los políticos no parecen dispuestos ni ahora ni en mucho tiempo.

La Comisión Europea comenzó un trabajo de revisión del marco regulatorio de las telecomunicaciones, como parte de la estrategia del Mercado Único Digital.

El primer paso fue la evaluación del Programa de Aptitud y Rendimiento Regulatorio (Regulatory Fitness and Performance Programme, REFIT).

Esto permitirá al

Cuerpo de Reguladores Europeos de Comunicaciones Electrónicas (Berec) y a los reguladores nacionales dar su punto de vista en la necesidad de reformar la manera de proporcionar datos reales a la Comisión en el marco legal actual.

El 2do paso fue en septiembre 2015 cuando la Comisión hizo una consulta pública sobre las reglas en telecomunicaciones.

Según Roberto Viola, director general suplente de la Comisión Europea, la revisión buscará si la regulación de las telecomunicaciones ha cumplido sus objetivos de mejorar el mercado interno y promover la competencia y los intereses de los usuarios finales. Luego buscará el

diseño de reglas para 2020 de “banda ancha (fija e inalámbrica) de alto rendimiento y basada en el mercado” para el Mercado Único Digital. El comisionado para la Economía Digital, Gunther Oettinger, dará más información al respecto en la feria IFA de Berlín en septiembre.

Uno de los principales objetivos de la reforma será asegurar que la competencia atraiga inversión y expanda la conectividad para todos, explicó Viola. Esto incluye la revisión de normativas de acceso y las metas de la conectividad, así como la creciente convergencia de los servicios fijos e inalámbricos y cómo pueden abordar la conectividad rural.

Como también se consulta a los operadores de telecomunicaciones, el análisis abordará cuestiones como igualdad de condiciones en términos de regulación para los servicios comparables.

Algunas reglas pueden estar limitadas a servicios específicos, mientras otras normativas como de protección al consumidor podrían ampliarse para aplicarse a una gama más amplia de servicios. Finalmente, la Comisión quiere asegurar que las nuevas reglas se apliquen de manera consistente en todos los Estados miembro de la Unión Europea. Esto se verá en las instituciones estructurales, como los reguladores nacionales, Berec y el Grupo de Política de Espectro Radioeléctrico.

EL CAMINO AL MERCADO DIGITAL UNICO

1 HITO. Europa 2020 y la Agenda Digital (Aprobado en 2010)

LA CONVERGENCIA DE SERVICIOS

La evolución de todos los mercados europeos se orienta hacia la convergencia, es decir, hacia la integración de servicios de

banda ancha fija con el móvil y la TV de pago.

Telefónica, fue el pionero en 2012, con el lanzamiento de

Movistar Fusión.

Deutsche Telekom en Alemania no inicia el modelo de la convergencia porque eso supone siempre una reducción de ingresos para el operador. Por tanto, tampoco Vodafone -que compró en 2013 Kabel Deutschland, el mayor grupo de cable alemán, para tener presencia en el fijo además de en el móvil- se ha aplicado con todas sus fuerzas.

HUTCHISON WHAMPOA

Hutchison Whampoa Limites (

HWL) del magnate Li Ka-shing está presente en el mercado móvil inglés a través de

Three UK, con la que pretendía fusionar O2 para crear un gigante capaz de competir con British Telecom (BT), el operador dominante. El grupo anunció que estudia emprender acciones legales contra Bruselas por impedir la compra de O2, la operación iba a conllevar una inversión de 12.672 millones de euros en el país.

HWL centrará ahora sus esfuerzos en fusionar su filial italiana

Three con

Wind Telecomunicazioni, una operación valorada en 25.000 millones de euros y que crearía un gigante a nivel local. La transacción pierde fuerza tras el bloqueo a la compra de O2, si bien en este caso cuenta con el apoyo del Gobierno que dirige Matteo Renzi.

El desafío digital al que se enfrentan las telecos para competir con Google o Facebook implica el desembolso de enormes inversiones, por lo que los analistas vienen años insistiendo en la necesaria "consolidación" del sector. En este sentido, los gigantes asiáticos están buscando acuerdos con las corporaciones europeas para alejarse de sus mercados -ya saturados- y entrar de lleno en Europa

ESPAÑA

Moviles: 50.36 millones a nivel nacional, según cifras recién publicadas por la Comisión Nacional de los Mercados y la Competencia (CNMC). con una penetración total de 108.5 líneas de telefonía móvil por cada 100 habitantes.

El segmento prepago cerró junio con un total de 13.83 millones.

El segmento pospago cerró abril con 36.52 millones, 72.5% de la base total de usuarios móviles.

Los Operadores Móviles Virtuales (OMV) tienen una cuota de mercado de

17 % al atender a 8.6 millones de teléfonos móviles en España.

Banda ancha fija española crece 5.2 % anual a un total de 12.82 millones, con una penetración total de 27.6 líneas por cada 100 habitantes..

Por tecnología, las líneas DSL se reducen y las líneas de HFC aumentan. Las líneas de fibra óptica (FTTH) superaron los 2 millones. El 79.5 % del total de líneas FTTH corresponde a Telefónica, con un parque de 1.6 millones de líneas.

FRANCIA

En Francia se registraron 4.3 millones de suscriptores de banda ancha superrápida (

30 Mbps+) a finales de

2015, 44 % más que en 2014, así lo dio a conocer el regulador de las telecomunicaciones

Arcep. Ello incluye 1.4 millones de conexiones FTTH, un incremento de 53 % en un año.

Los clientes sobre conexiones

100 Mbps+ alcanzaron 1.425 millones al final de diciembre de 2015. Las adiciones FTTH incrementaron por 500,000 en 2015. Las suscripciones a planes de

30-100 Mbps alcanzaron 1.64 millones a finales de diciembre, un incremento anual de 44%. Estos incluyen planes VDSL2, todos ellos ofreciendo 30 Mbps+.

El número de conexiones a Internet con velocidades de descarga

menores a 30 Mbps se redujo a 22.6 millones de instalaciones. Tales clientes representaron 85 % de todas las suscripciones de banda ancha y banda ancha superrápida a finales de 2015. Las suscripciones de banda ancha y banda ancha superrápida se situaron en

26.9 millones a finales de diciembre, un incremento anual de 3.4%.

Los hogares con

más de 30 Mbps+ de servicios descendentes incrementaron 9% en un año a 14.5 millones a finales de diciembre, de los cuales 5.6 millones de hogares pasaron con FTTH, 38 % más que hace un año.

Los operadores alternativos desagregaron 9,526 intercambios de cobre al bucle local a finales de 2015, un aumento de 800 intercambios en un año, y ahora sirven 91.7 % de todas las líneas. Los operadores alternativos han comprado más de 13.6 millones de conexiones al por mayor desde Orange a través de LLU.

Las actualizaciones de cable coaxial continúan, con unos 8.8 millones de hogares equipados para 30 Mbps+ FTTLA y accesos HFC, incluidos 7 millones capaces de ofrecer 100 Mbps+. Algunos de los 3.8 millones de hogares están localizados fuera de las zonas de muy alta densidad.

El número de hogares FTTH creció un 38 % en el año a

5.6 millones al final de 2015. Unos 2.2 millones están ubicados fuera de las zonas de muy alta densidad y 881 mil están servidos por las redes propiedad del gobierno local (PINs).

Cerca de 3.5 millones de hogares, o 62 % de hogares elegibles para FTTH podían elegir entre al menos dos proveedores de acceso a fibra al final de 2015. Arcep atribuye este 35 % de ganancia anual a los esquemas de reparto de red introducidos por la regulación nacional.

A fines del 2015, 14.5 millones de hogares en Francia fueron capaces de suscribirse a un servicio de acceso de banda ancha superrápida, incluidos 9 millones de hogares (62%) situados fuera de las áreas de muy alta densidad.

ITALIA

Fastweb: Su plan de fibra óptica busca duplicar sus actuales velocidades de conexión a banda ancha, de 100 a 200 Mbps, y extender su red a 50 % de la población italiana en 2020. Para 2016, se ha comprometido a ampliar su cobertura de fibra óptica a 30 % de los habitantes en Italia (7.5 millones de hogares).

Fastweb garantizó nuevas tasas de velocidades en 30 ciudades, lo que representa 25 % de su red. En 2017, llegará a 60 ciudades (70%) y en 2018 alcanzará a 100 %de las 100 ciudades cubiertas.

Vodafone Italia: lanzó una oferta de fibra al hogar (FTTH) de

500 Mbps en las ciudades de Milán, Turín y Boloña. Son los primeros en alcanzar dicha velocidad en el país

El servicio de 500 Mbps se ofrece sobre la infraestructura desplegada por

Metroweb. El propio sistema de fibra de 100 Mbps de Vodafone pasa por 8.5 millones de hogares y negocios en 270 ciudades y pueblos italianos

Telecom Italia obtuvo un beneficio neto atribuido de 29 millones de euros en 1er semestre 2015, lo que representa una caída del 94,6% con respecto al mismo periodo de 2014.

Telecom Italia precisó que sus cuentas del primer semestre reflejan el impacto de cargas extraordinarias, así como del coste de operaciones de recompra de deuda. "En ausencia de estos impactos, los beneficios del primer semestre habría superado los 650 millones de euros", añadió la empresa.

Los ingresos de Telecom Italia entre enero y junio sumaron un total de

10.097 millones de euros, un 4,3% menos que en el mismo periodo de 2014, mientras que su beneficio operativo disminuyó un 19,9%, hasta 1.782 millones.

La facturación en Italia retrocedió un 2,1%, mientras que aumentó un 5,7% en los mercados internacionales. Los ingresos en Brasil bajaron un 10,7% en comparación con el año anterior.

El grupo de medios francés

Vivendi aumentó su participación accionaria en Telecom Italia a

14.9 %, reemplazando a Telefónica como mayor accionista de

Telecom Italia.

Vivendi recibió 8.24 % de las acciones de Telecom Italia de manos de Telefónica como parte del pago por la venta de su unidad de

banda ancha brasileña GVT, que cerró el 28 de mayo. Telefónica vendió su participación en Telco después de 8 años, y dejó a los cuatro inversionistas restantes la libertad para vender sus acciones.

ALEMANIA . una sociedad gigabit

El gobierno de Alemania asignó un adicional de 1,300 millones de euros (mde) para la expansión de redes de banda ancha de alta velocidad en las partes marginadas del país, de 2, 700 mde que el Ministerio Federal de Transporte e Infraestructura Digital (

BMVI) ya tenía disponibles, con lo que el fondo total ahora es de 4,000 mde, para el desarrollo de “una sociedad gigabit”, por lo que es necesario que toda Alemania cuenta con Internet ultrarrápido.

Las autoridades de las entidades locales (en áreas rurales y remotas) pueden subvencionar a los operadores de telecomunicaciones de dos maneras, ya sea mediante el apoyo financiero a la implementación económicamente poco atractiva de las redes de banda ancha por un operador de telecomunicaciones, o a través de la instalación de redes de banda ancha a sí mismas y luego alquilando su infraestructura a proveedores

REINO UNIDO

Las compañías de telecomunicaciones buscan converger las redes y servicios fijos y móviles a través de la adquisición de sus rivales, pero el regulador quiere evitarlo bajo el argumento de conseguir el beneficio de los usuarios. Los 4 principales operadores móviles en el Reino Unido son Everything Everywhere (EE), O2 (Telefónica de España), Three (Hutchison de Hong Kong) y Vodafone.

British Telecom (BT), adquirió al operador líder de telefonía móvil

Everything Everywhere (EE) , y la unión de Orange y Deutsche Telekom- fue un acuerdo valorado en 16,250 millones de euros.. La transacción fue aprobada por la Autoridad de Mercados y Competencia el 15 de enero 2016.

BT como

EE son operadores locales y no tienen presencia en otros mercados europeos, por lo que la decisión recayó solo en el regulador de competencia local.

A diciembre de 2015, EE registró 31.478 millones de conexiones, con una cuota del mercado móvil de 31 %. British Telecom comenzó en marzo de 2015 a ofrecer servicios móviles 4G como un operador móvil virtual (OMV) con la tecnología de EE, antes de que se concretara la adquisición de la telefónica móvil más grande del país. British Telecom capturó 71% de participación en el mercado de banda ancha del Reino Unido.

En marzo de 2015 el consorcio de Hong Kong, Hutchison Whampoa, a través de su filial en el Reino Unido,

Three, anunció la adquisición del operador

O2 de Telefónica por 14,000 mde. O2 es el segundo operador móvil del Reino Unido, seguido de Three, y su unión con O2 haría surgir a la compañía móvil más grande del país.

En octubre de 2015 la Comisión Europea (CE) abrió una investigación sobre este movimiento. La CE ejerció sus facultades en el mercado comunitario porque Hutchison también tiene operaciones en Irlanda, Austria e Italia, mientras que Telefónica también participa en el territorio alemán.

Hasta antes de la aprobación, BT no tenía una participación en el mercado móvil, por lo que la compra de EE completaba la convergencia de servicios del operador, añadiendo el componente móvil. Asimismo, la transacción dejaría intacto el mercado móvil con cuatro operadores principales, pero aseguraría la inversión en redes de cuarta generación, pues EE se caracteriza por tener el mayor número de suscriptores 4G-LTE en el país. Es decir, la Autoridad de Mercados y Competencia advirtió que la consolidación BT-EE traería beneficios al consumidor en términos de precios, redes y servicios convergentes e inversión.

En cambio, la consolidación entre O2 y Three implicaría la reducción de cuatro a tres operadores móviles, con hipotéticos efectos (según las autoridades de competencia) sobre el alza en las tarifas de los servicios. Asimismo, evidencia la imposibilidad de Telefónica de competir en un mercado convergente fijo-móvil, pues la filial de la telefónica ibérica carece de redes alámbricas en el Reino Unido. La pérdida competitiva de O2 se convertiría en ventaja para Three al adquirir los activos y suscriptores de O2. Con la intención de zanjar los obstáculos regulatorios, Hutchison habría ofrecido a la Comisión Europea habilitar un tercio de su capacidad de red para otros operadores en el Reino Unido. La estrategia del grupo de Hong Kong buscaría evitar que entrara al mercado un cuarto operador móvil que desplegara e invirtiera en redes.

Quienes también dan seguimiento al caso O2-Three son algunos de sus rivales (Virgin Media, Sky, TalkTalk, Vodafone y BT), los cuales están interesados tanto en los activos sobrantes de la nueva compañía como en la imposición de determinadas cláusulas para facilitar la entrada de un nuevo jugador.

Hasta agosto de 2015,

Three contaba con 8.8 millones de clientes, de los cuales 4.9 millones eran suscriptores 4G.

O2 cerró 2015 con 14 millones de usuarios. Si la Comisión Europea autoriza la compra, el gigante móvil poseería aproximadamente 23 millones de clientes en el Reino Unido.

En febrero 2016,

Virgin Media, que brinda banda ancha fija, televisión por cable, telefonía y servicios móviles bajo la figura de Operador Móvil Virtual (OMV), hizo público su apoyo a la oferta de Hutchison por O2, la cual “podría tener más que ofrecer a los consumidores y, sobre todo, una mayor capacidad para otros proveedores que quieren impulsar la competencia en su propio derecho. Con los remedios adecuados, este acuerdo podría estimular [y] no limitar la competencia”, escribió Tom Mockridge, director Ejecutivo de Virgin Media. El OMV cuenta con 3 millones de clientes en el Reino Unido.

Sky también busca jugar con la convergencia fijo-móvil, puesto que posee una cuota de mercado de 22 % en banda ancha, mientras que en 2015 comenzó un acuerdo con O2 para hacer uso de sus redes. Para la directora de estrategia de Sky, Mai Fyfield, la fusión entre las filiales de Hutchison Whampoa y Telefónica “sería una buena situación para todos los operadores móviles virtuales que utilizan su red en el sentido de la inversión continua en esa red”.

Xavier Niel, dueño del operador francés Iliad (Free Mobile), tiene interés de ingresar al mercado británico en caso de que la entidad fusionada llegue a vender parte de sus activos.

El 22 de abril 2016 la Comisión Europea anunciará la resolución definitiva. Aunque se pronostica un sentido a favor de la fusión más que en contra de la adquisición, se encuentra un antecedente protagonizado por TeliaSonera y Telenor, los cuales decidieron abandonar el proyecto de fusión de sus operaciones en Dinamarca ante la imposibilidad de llegar a un acuerdo con la comisaria de Competencia de la Unión Europea, Margrethe Vestager, para cumplir determinadas condiciones, como la entrada de un cuarto operador móvil en aquel país.

La comisaria y la directora ejecutiva del regulador de las comunicaciones del Reino Unido (Ofcom), Sharon White, han manifestado su preocupación por la reducción de operadores móviles al argumentar que la consolidación del mercado móvil en cada país podría conducir a precios más altos para los consumidores y las empresas, así como un “cambio en el equilibrio de poder” entre los operadores y los minoristas independientes.

ECONOMIA DIGITAL EN UK.

UK planea la Ley de Economía Digital. El gobierno indicó que esta legislación permitirá la construcción de infraestructura digital de clase mundial, incluidas redes móviles y banda ancha rápidas. Asimismo, se cumplirá con el compromiso manifiesto del gobierno para desplegar banda ancha universal y mejorar las conexiones de telefonía móvil.

El proyecto de ley introducirá una nueva obligación de servicio universal de banda ancha que dará a todos los hogares el derecho legal a una conexión de banda ancha rápida.

En cuanto a las velocidades de acceso, el gobierno espera que la tasa de descarga mínima sea de al menos

10 Mbps inicialmente. La Oficina de Comunicaciones (

Ofcom) tenga la facultad de revisar la velocidad de Internet.

La nueva legislación incluirá un nuevo Código de Comunicaciones Electrónicas, diseñado para reducir el costo de la construcción de

antenas de telefonía móvil y de cables de banda ancha

La ley otorgará a la Ofcom el poder para que ordene a los proveedores de servicios ofrecer datos, como quejas de los clientes y las velocidades de banda ancha. Existirá un nuevo derecho para que los consumidores tengan derecho a una compensación automática cuando tengan un mal servicio de banda ancha.

MERCADO DE MEDIOS

15 grupos de distribución paneuropeos de contenidos para TV sirven a dos tercios de los hogares de TV de pago en la Unión Europea, según los datos de análisis del mercado de los medios de comunicación del Observatorio Audiovisual Europeo.

Los grupos de medios de radiodifusión paneuropeos se pueden distinguir entre los que tienen una estrategia de difusión multi-país que proporciona muchos canales de

free to air, y los que tienen una estrategia más europea con

marcas de canales conocidos y disponibles en toda Europa.

Los 2s principales grupos de radiodifusión reunieron el 51% de la audiencia, y si se toman los tres grupos principales la participación en la audiencia llega al 64%, con fuertes variaciones entre países.

Deutsche Telekom, Liberty Global, Orange, Sky, Viasat y Vivendi se encuentran entre el grupo de los 15 que domina la televisión en la Unión Europea y que representan a la mitad de los suscriptores de TV paga. Los especialistas de televisión abierta, como CME y RTL también cuentan.

Los principales grupos panregionales de canales son de USA. En el Top 15 hay 9 firmas de USA, incluyendo

21st Century Fox, AMC Networks, Discovery Communications, NBCUniversal, Scripps Networks, Sony Corporation, Time Warner, Viacom y The Walt Disney Company.

AMERICA MOVIL: La expansión en Europa

América Móvil tiene dificultades para crecer en Latinoamerica,

mientras que tiene poca incursión en Europa que presenta muchas opciones para

realizar adquisiciones en una etapa de consolidación de la industria.

Tras haber intentado adquirir a la holandesa KPN, América Móvil (AMóvil)

acelerará su expansión en el Este y Centro del Viejo Continente a

través de

Telekom Austria en la cual posee 60% de sus acciones.

“Vamos a invertir muy fuerte en Europa en el despliegue de

infraestructura en los próximos años… es un mercado con mucho potencial…

no descartamos la compra de más empresas”, dijo Carlos García Moreno,

CFO de América Móvil.

AMóvil

empezará por aumentar su participación y rentabilidad en los países de

Europa del Este, incluyendo a Austria, Bielorrusia, Bulgaria, Croacia,

Eslovenia, Macedonia y Serbia, donde tiene 20 millones de suscriptores.

AMóvil

podría incursionar fácilmente en países como Polonia, República Checa,

Hungría y Rumanía con una estrategia enfocada a esquemas de

prepago atractivos para posteriormente convertir a estos en usuarios de pospago.

Una

tercera etapa sería apostar por mercados más maduros como Alemania,

Suiza y otros de Europa del Norte, donde competiría con gigantes como

Telefónica, Vodafone, T-Mobile y Orange.

Todo esto, ante las regulaciones estrictas que América Móvil enfrenta en

México, donde busca escindir activos para

salir de la preponderancia, y debido a que es líder en la mayoría de los 17 mercados latinoamericanos donde tiene presencia.

El mercado europeo tiene un valor equivalente al estadounidense, con

443,000 millones de euros (mde) y

438 millones de líneas asociadas a un smartphone.

En

2014, América Móvil destinó al mercado europeo, el 75 % de sus

inversiones en adquisiciones y licencias, de acuerdo con su informe

anual.

En 2015 AMóvil planea

invertir 8,900 millones de dólares a nivel global y los analistas estiman montos similares para los siguientes años, cada vez más enfocados a Europa.

En el 2014,

Telekom Austria generó a América Móvil ventas equivalentes al 4.4 % de sus ingresos consolidados.

El

mercado de Europa del Este tiene un gran potencial de rentabilidad en

comparación con México. Al cierre del primer trimestre del 2015, el

margen EBITDA de AMóvil en México fue de 32%, frente al 14 % de Europa

del Este.