de rendimiento mínimos. Para asegurar la calidad de servicio (QoS), los proveedores tienen que configurar sus redes para definir como será priorizado el tráfico de la red. Esto se lleva a cabo asignando diferentes niveles de prioridad dependiendo del tipo de servicio y ajustando la configuración de la red con algoritmos de prioridad.

Las tramas ethernet se marcan en un campo específico para poder diferenciar el tráfico, y esto permite a los elementos de red diferenciar y discriminar el tráfico según la prioridad que tenga.

SLA (service-level agreement)

El acuerdo de nivel de servicio (SLA) es un contrato entre el proveedor de servicio y el cliente, que garantiza que se cumplirá un rendimiento mínimo para los servicios. Ejemplo de SLA

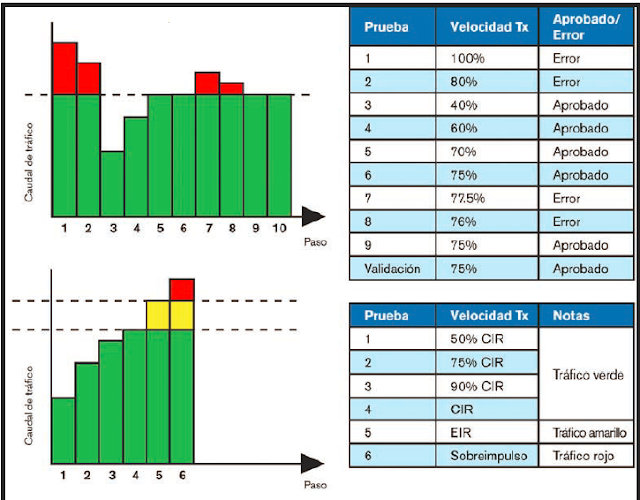

El tráfico del cliente se puede clasificar en 3 clases diferentes con su equivalencia de color: verde para tráfico garantizado, amarillo para tráfico en exceso y rojo para tráfico descartado.

El tráfico verde (CIR, committed information rate) se refiere al ancho de banda que está disponible

de forma garantizada siempre para un servicio específico y donde los KPIs (key performance indicators) se cumplen de forma garantizada.

El tráfico amarillo (EIR, excess information rate) se refiere al exceso de ancho de banda por encima

del CIR que puede estar disponible dependiendo del uso de la red, y donde los KPIs no están garantizados.

El tráfico rojo (descartado) se refiere al tráfico por encima del CIR o del CIR/EIR y que no puede ser transmitido sin descartar otros servicios. Es, por tanto, destruido

Los KPIs son características específicas de tráfico que indican el rendimiento mínimo de un tipo concreto de tráfico. Cuando el tráfico es verde, la red debe garantizar estos requerimientos mínimos para todo el tráfico. Los indicadores típicos KPI son: ancho de banda, retardo de tramas (latencia), pérdida de tramas y variación del retardo de tramas (jitter).

RFC 2544

La metodología de test que mas se usó para Ethernet fue la RFC2544. Esta serie de tests proporciona una metodología para medir el ancho de banda, la latencia de ida y vuelta, la pérdida de paquetes y las ráfagas. Se introdujo inicialmente como una metodología para testear dispositivos en laboratorio, pero como era el único estándar disponible, se usó también para testear servicios Ethernet en campo.

Aunque esta metodología proporciona parámetros clave para calificar la red, no es suficiente hoy en día para validar completamente los servicios Ethernet. Por ejemplo, RFC2544 no proporciona medidas de jitter, medidas QoS y niveles de servicio concurrentes. Además, el RFC2544 requiere

la realización de tests secuenciales para validar completamente el SLA, y esto puede llevar varias horas, cosa que consume tiempo y dinero a los operadores. Ahora existe un nuevo requerimiento, que es simular todos los tipos de servicios que funcionen en la red y que califiquen simultáneamente

todos los parámetros SLA para cada uno de estos servicios.

Estas pruebas habilitan la completa validación de todos los parámetros SLA en un único test para optimizar la QoS. Al contrario que otras metodologías, permite multiservicios. De hecho, Y.1564 simula todos los tipos de servicio que corren en la red simultáneamente para calificar los parámetros clave del SLA para cado uno de estos servicios. También valida el mecanismo QoS provisionado en la red para priorizar los distintos tipos de servicios, dando lugar a una validación más exacta, y un despliegue y resolución de incidencias más rápido. Además, brinda resultados bidireccionales.

Y.1564 comprueba para cada servicio el nivel CIR (con el cumplimiento de los KPIs), el EIR, y el tráfico descartado.

Esto se realiza para cada uno de los servicios presentes en la red.

METODOLOGIA DE PRUEBA:

Consta de 3 fases:

Fase1: Prueba de configuración de servicios

Fase2: Prueba de perfomance de servicios

Fase3: Prueba de ráfagas

1. PRUEBAS DE CONFIGURACION DE SERVICIOS ( Prueba de Rampa)

Para cada servicio se utiliza la prueba de rampa alcanzando y excediendo gradualmente el CIR. Todos los indicadores KPIs son medidos y comparados con los umbrales establecidos.

2. PRUEBAS DE RENDIMIENTO DE SERVICIOS

Todos los servicios son generados a la vez a su CIR correspondiente, todos los indicadores son medidos para todos los servicios.

3. PRUEBAS DE RAFAGAS DE TRAFICO

Permite comprobar que los tipos de ráfagas esperadas puedan ser transmitidas con una pérdida mínima.

CBS: Tamaño de ráfaga comprometida (Committed burst size): Número de bytes disponibles para las ráfagas transmitidas a tasas temporales por encima del CIR garantízado del SLA.

EBS: Tamaño de ráfaga en exceso (Excess burst size): Número de bytes asignados disponibles para las ráfagas enviadas a tasas temporales por encima del CIR + EIR.

• Se prueba individualmente en cada dirección para asegurar si la politica o mecanismo de conformación está configurado correctamente

• secuencia de descarga se puede repetir para el valor configurable por el usuario

TOPOLOGIAS DE PRUEBAS

1.Desde un extremo: Requiere un equipo de prueba en un extremo y en el otro se hace un bucle lógico con un equipo simple. Se obtiene la medida en solo sentido

2. Bidireccionales: Requiere 2 equipos de pruebas. Se obtiene medidas en ambos sentidos

COMPARATIVO RFC2544 VS Y.1564

Comparación entre un test RFC2544 y un test Y.1564 para el mismo servicio. Y.1564 es mucho más rápido.